¿Machine learning? ¿Livecoding? Cuatro artistas locales te explican todo sobre la movida

Deepfakes, arte y memes: qué son y cómo se hacen

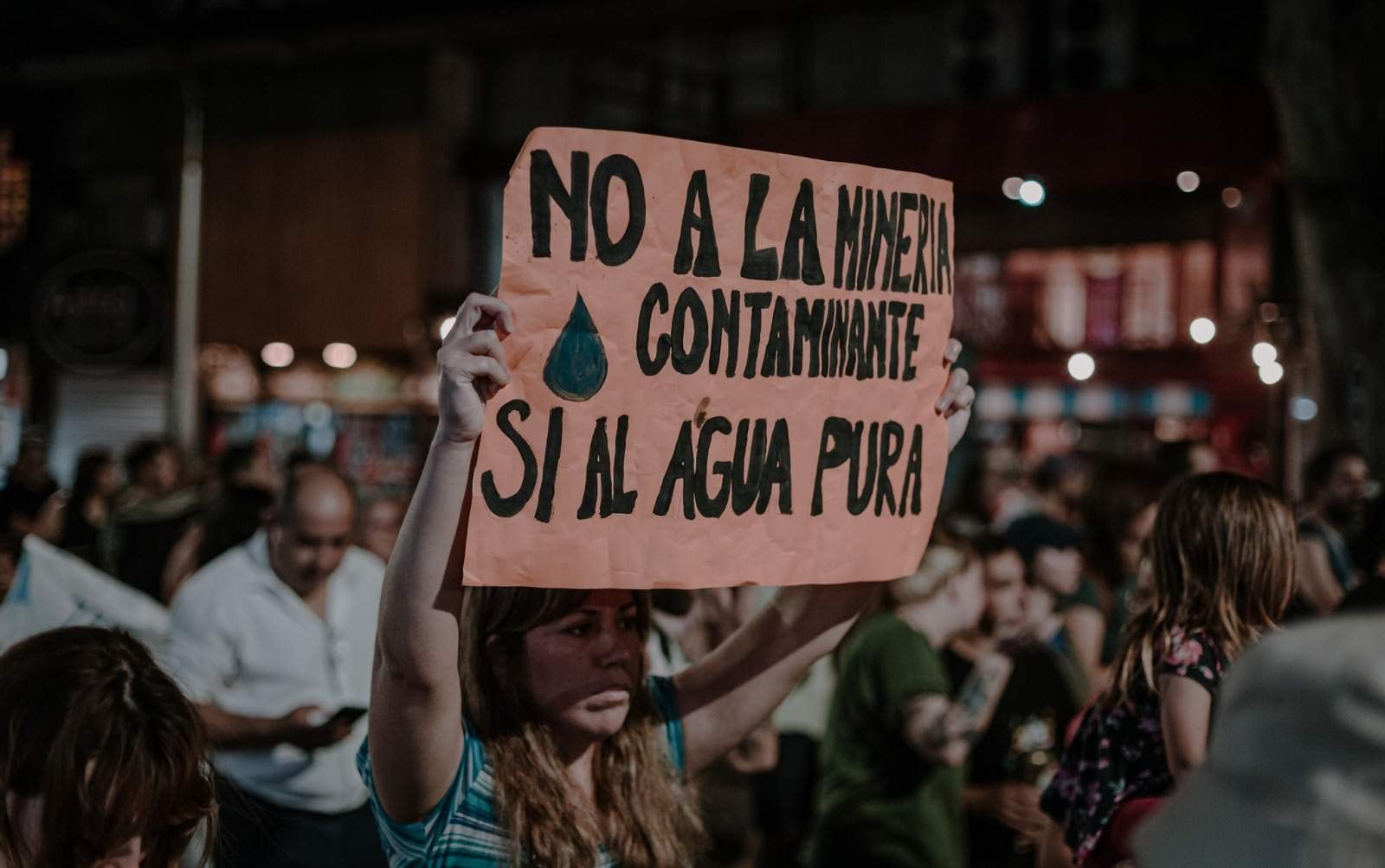

Mathias Gatti hace rapear a Trump, Maja punkea código, Mer hackea la belleza hegemónica y Tutanka renueva el chiste político.