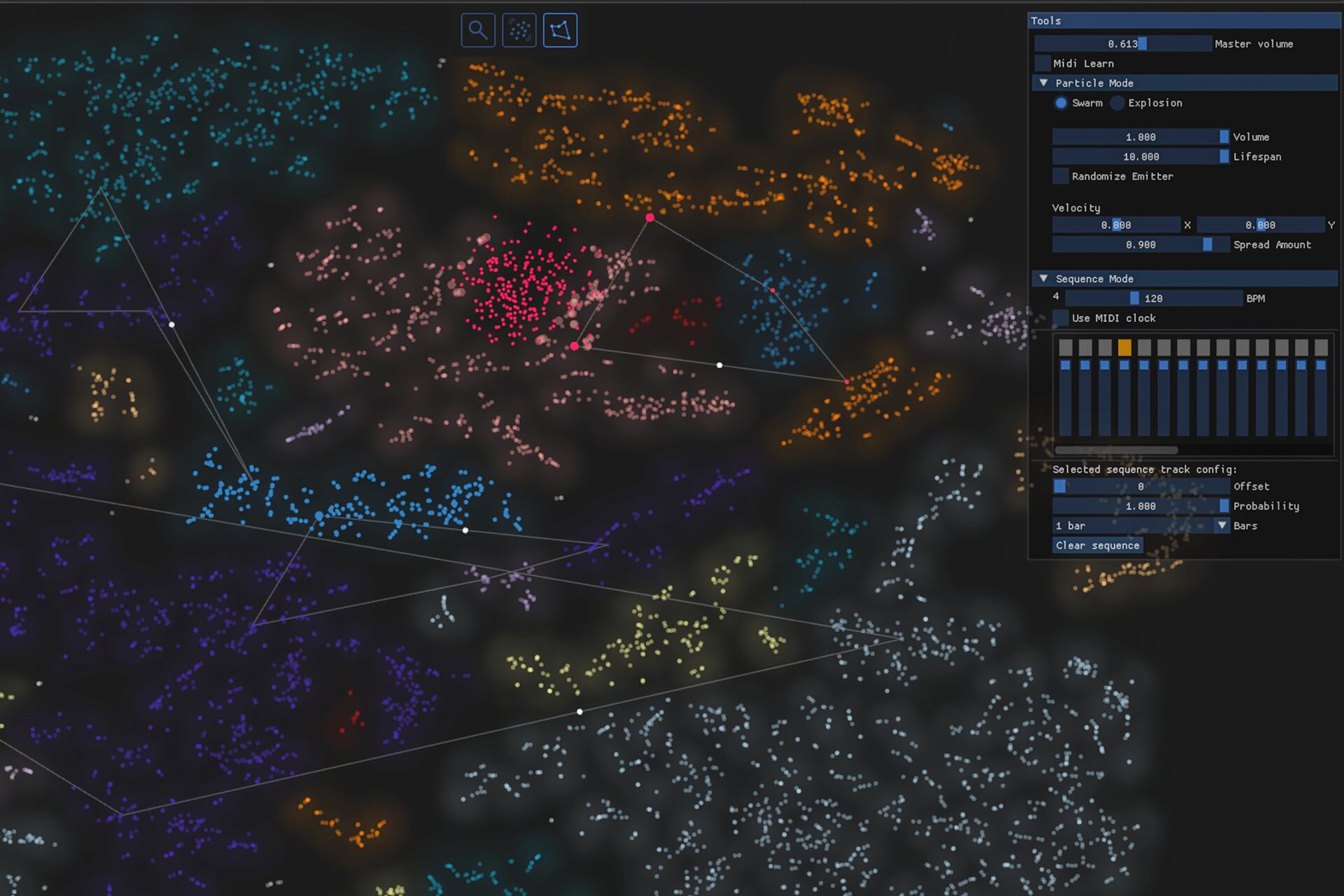

Una herramienta musical de código abierto para explorar sonidos mediante visualizaciones

AudioStellar, un viaje a las galaxias sonoras

El software gratuito llevado a cabo en la Untref permite organizar y manipular librerías de sonido mediante un mapeo tímbrico.