Si, sosteniendo el celular con la mano, se mira una aplicación en la pantalla de inicio y se acerca el teléfono a los ojos, la aplicación se abre. Si, mientras se lee una página web, aparece una notificación en la parte superior de la pantalla, se mira y se gira ligeramente el teléfono a la derecha para borrarla o se acerca a los ojos para abrirla y verla en detalle y se aleja para cerrarla.

En una galería de fotos, basta con mirar a una imagen para que se abra, acercar el teléfono a los ojos la amplía y un ligero movimiento del teléfono a la izquierda o la derecha permite aplicar diversos filtros. En el correo electrónico, acercar el teléfono mientras se mira un mensaje lo abre y alejarlo lo cierra. Estas son algunas de las posibilidades que presenta la nueva interfaz EyeMU basada en el rastreo ocular que está desarrollando el Grupo de Futuras Interfaces de la Universidad de Carnegie Mellon (EEUU).

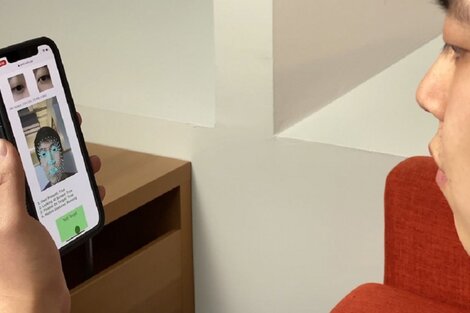

Los investigadores no pretenden facilitar el control del teléfono móvil con los ojos a personas con discapacidad, como ha sido normalmente el objetivo de esta tecnología que tiene detrás una gran labor de investigación, sino facilitar a cualquiera el uso de móviles cada vez más grandes que son difíciles de controlar con una sola mano. "Mostramos cómo el rastreo ocular que hace la cámara que enfoca al usuario se puede combinar con movimientos que registra la herramienta para disponer de una nueva técnica de interacción intuitiva y rápida en móviles que sostiene el usuario", explican en el trabajo, liderado por Chris Harrison, que han presentado en un congreso.

Karan Ahuja: "Tienes que asegurar que los algoritmos son lo suficientemente rápidos"

Los sistemas de rastreo ocular son normalmente caros y no aplicables a los móviles, por lo que este equipo se planteó adaptarlos sin necesidad de añadir nada al aparato, y combinarlos con las propias aplicaciones y funcionalidades. "Si miras una pantalla de inicio sin más, terminarían abriéndose muchas aplicaciones", dice Harrison. Es el perfeccionamiento del software lo que permite seguir el movimiento de los ojos con tanta precisión y una respuesta tan rápida que se adelanta a lo que quiere el usuario antes de que realice cualquier acción como tocar la pantalla o dar un comando de voz. "Tienes que asegurar que los algoritmos son lo suficientemente rápidos", señala Karan Ahuja, un miembro del equipo. "Si tardan demasiado el ojo se moverá hacia otro lado".

Las grandes empresas tecnológicas como Google y Apple han avanzado mucho en el desarrollo del rastreo ocular, y EyeMU se basa en la tecnología Google Mesh para establecer en primer lugar los patrones oculares de cada usuario. Para que se active la herramienta, el usuario debe de estar mirando de frente a la pantalla del móvil y entonces aparece una notificación. "La verdadera innovación es la suma de otra modalidad que se combina con el rastreo ocular, como girar ligeramente el teléfono en diversas direcciones o acercarlo o alejarlo. Eso es lo que lo hace tan poderoso", finaliza Harrison, quien cree que esta técnica u otra basada igualmente en datos biométricos estará pronto disponible en los móviles.

Google se ha propuesto acelerar la investigación en este campo para conseguir sistemas fiables y asequibles

EyeMU es solo un ejemplo de cómo se puede aplicar el seguimiento ocular a través de la cámara del móvil. Google se ha propuesto acelerar la investigación en este campo para conseguir sistemas fiables y asequibles con objetivos muy ambiciosos. Prevén, en un artículo publicado en Nature Communications, aplicaciones en las áreas de la visión, la accesibilidad, el cuidado de la salud y el bienestar. Afirman que su sistema con el móvil proporciona resultados tan fiables como los sistemas anteriores, fijos o portátiles, en el estudio del funcionamiento visual del cerebro, o la detección de dificultades en la comprensión de lo leído.

El rastreo ocular es una herramienta importante para detectar el estado de alerta y de bienestar en medicina, estudio del sueño, operaciones quirúrgicas y la seguridad aérea entre otros, explican estos investigadores, quienes creen haber demostrado que el realizado a través del teléfono móvil puede utilizarse para detectar el principio y la progresión de la fatiga. La persona tiene que hacer dos tareas mirando el móvil y cómo las hace indica su grado de fatiga.

Finalmente, pero no menos importante, está la accesibilidad, la posibilidad de utilizar los ojos para comunicarse en personas con dificultades motoras o para hablar. Un ejemplo es el sistema Look to Speak , ya disponible, con el que una persona sin habla selecciona con los ojos una frase de la lista que se le presenta en la pantalla, frase que el móvil dice. Las frases se pueden personalizar.

Sin embargo, el rastreo visual es un subproducto del reconocimiento facial , una tecnología que se puede utilizar para objetivos no deseables, como ya está aplicando en China para vigilancia y control de la población. El uso de esta tecnología, para cualquier objetivo, limitado o general, debería obtener el consentimiento informado del usuario en todos los casos, señalan los investigadores de Google Research Nachiappan Valliappan y Kai Kohlhoff.