Un nuevo acuerdo para regular los avances en el área

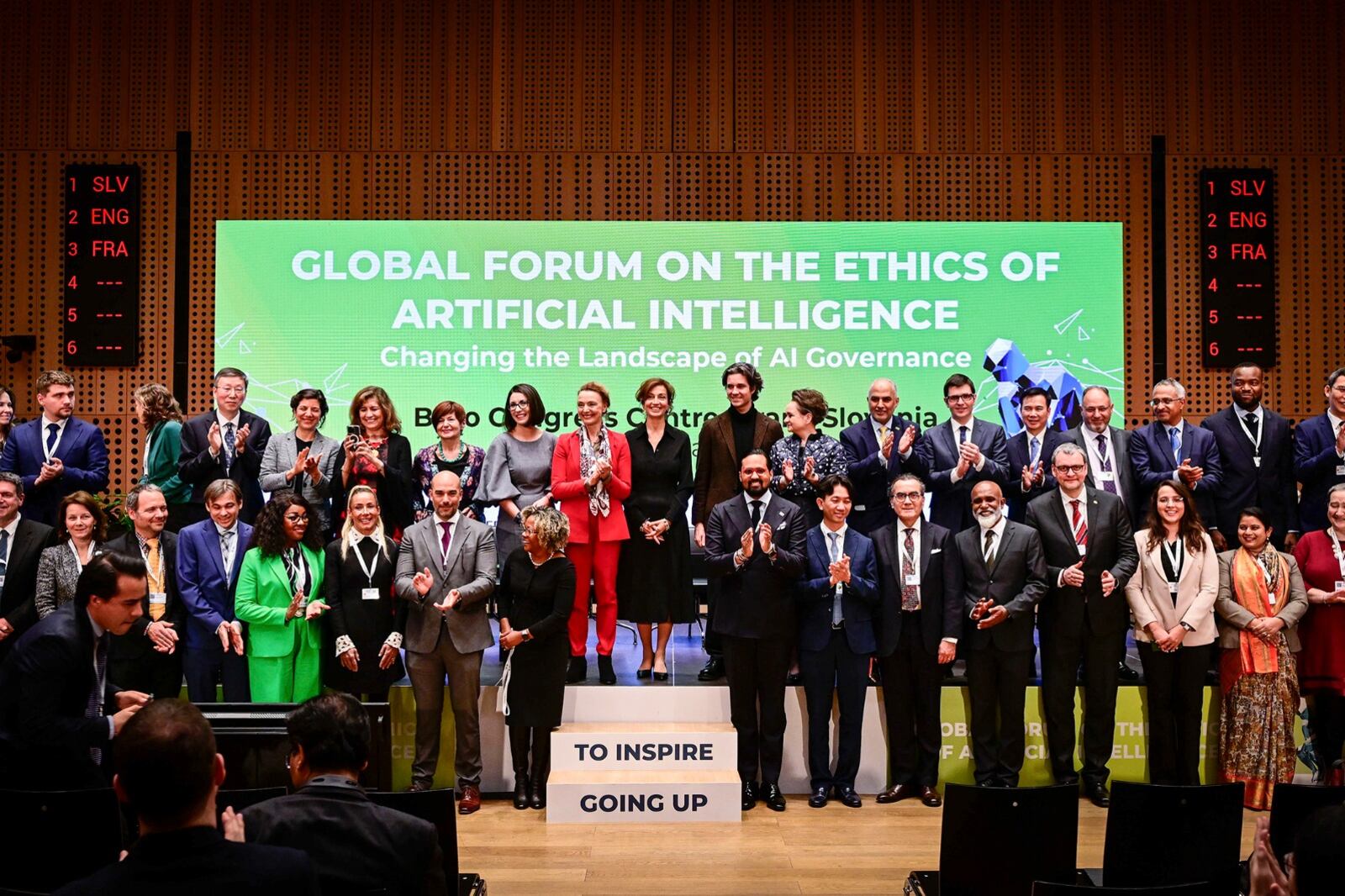

Ocho empresas tecnológicas se comprometieron a desarrollar una IA con ética

Las compañías firmaron junto a la Unesco un documento para que los próximos desarrollos de IA que realicen tengan un enfoque de derechos humanos. Los compromisos de los privados y los intentos de control previos.