![]()

![]()

![]() Miércoles, 18 de junio de 2014

| Hoy

Miércoles, 18 de junio de 2014

| Hoy

CIENCIA › DIáLOGO CON FERNANDO MONTANI, DOCTOR EN FíSICA E INVESTIGADOR DEL CONICET

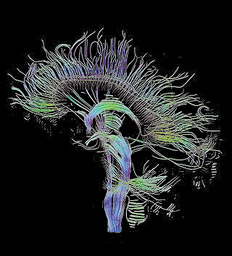

Por los insondables caminos del cerebro

Nuestra cabeza está poblada de misterios. Las neurociencias, desde esta perspectiva, ensayan modelos matemáticos para comprender cómo funciona el cerebro y cómo se vinculan las poblaciones neuronales ante estímulos externos.

Por Leonardo Moledo

Por Leonardo Moledo

–Cuénteme.

–Yo volví al país en el 2009 con el plan de repatriación de científicos, después de haber estado trabajando en Alemania, Bélgica, Inglaterra e Italia. Soy físico de formación, y ahora estoy trabajando en neurociencias teóricas, más específicamente en código neuronal. Lo que hago son aproximaciones matemáticas para investigar ese código.

–Desarrollemos un poco.

–Lo que hago es tratar de darle soporte a la neurociencia desde la física y desde la matemática. Lo que intentamos es desarrollar determinados modelos matemáticos para comprender ciertos comportamientos del cerebro ante estímulos externos.

–¿Cuáles, por ejemplo?

–Sensoriales. Esos serían los más directos, pero existen otros estímulos menos directos. Cuando uno agarra un objeto, se produce un estímulo que –claramente– es muy evolucionado y está relacionado con la corteza premotora y motora. Cómo reacciona esa corteza es todo un objeto de estudio. Yo me he ocupado de tratar de entender un poco más eso, y de tratar de dar una visión diferente de la que podría tener un biólogo con una formación puramente biológica.

–A ver...

–En la escuela tradicional, los físicos estamos completamente separados de los ingenieros, de los biólogos, de los médicos. En la disciplina en la que yo trabajo se intenta que todas estas vertientes confluyan y, así, poder romper con la escuela tradicional. Es todo un desafío.

–¿Cómo son los modelos?

–Se usan dos técnicas: una es de Teoría de la Información y la otra es de Sistema Dinámico. A partir de ahí uno intenta desarrollar modelos matemáticos y computacionales que expliquen datos que son simulados, o bien, que son tomados de laboratorios del trabajo con animales. En 1956, más o menos, dos científicos ingleses propusieron una ecuación que simulaba a través de sistemas dinámicos el comportamiento de una neurona. El desafío es cómo extender eso cuando uno tiene poblaciones de neuronas. Son técnicas que se utilizan a través de sistemas dinámicos, que permiten obtener un modelo minimal para representar esa población. A partir de ahí se hace el contraste con datos experimentales y a partir de técnicas de Teoría de la Información se puede entender mejor cómo se empaqueta la información de acuerdo con los distintos estímulos.

–¿Cómo se empaquetan?

–Depende del problema particular que tomemos. En uno de mis trabajos descubrí que cuando los monos ven líneas que se mueven la información se transmite increíblemente rápido al cerebro. En cambio, cuando hay cambios de color, son prácticamente insensibles, lo cual evidentemente muestra que hay una gran sensibilidad a los cambios de movimiento. Después, fui evolucionando hacia cosas en la corteza motora, a tratar de entender otros problemas no relacionados con la corteza visual. La idea general es ver cómo las poblaciones de neuronas trabajan o funcionan, cómo se correlacionan, de a cuántas se correlacionan... Es un enfoque que requiere de una matemática sofisticada, pero muy estimulante.

–Vayamos a lo micro.

–Lo que intento ver es cómo el código de correlaciones se diferencia de un código completamente lineal. Si en el futuro pensamos desarrollar una interfase cerebro-máquina, tener un algoritmo que contemple esas correlaciones es esencial.

–¿Cómo es ese algoritmo?

–Completamente no lineal.

–¿Cómo se propaga una señal en el cerebro?

–Hay varias frecuencias de las cuales nos tenemos que preocupar, desde las frecuencias más bajas –menores que 250 hertz– hasta las frecuencias más altas, los potenciales de acción. Hay dos frecuencias de trabajo que están relacionadas con los inputs y los outputs de las neuronas. Las frecuencias bajas están relacionadas con el network y las frecuencias más altas están relacionadas con los inputs. Por intermedio de esa señal, uno puede tratar de entender cómo se transmite la información. Y son los potenciales de acción los primeros que nos hablan de la transmisión de la información en una neurona. Pero hay que pensar que el cerebro tiene millones de neuronas y, por ende, billones de potenciales de acción que están conectados. Eso para las frecuencias altas; para las frecuencias bajas es una señal de unos poquitos hertz, con una longitud de onda muy grande, que se relaciona con el network. Hay dos problemas separados, entonces, y es ahí donde tenemos que entender cómo se propaga la información. A nivel divulgativo: la información se propaga mediante potenciales de acción. Pero eso es para una neurona, y los potenciales de acción están correlacionados.

–¿Qué es un potencial de acción?

–Las neuronas son células y, como tales, están en equilibrio. En este sentido, poseen un potencial de equilibrio que es negativo. Cuando existe algún estímulo externo (un estímulo sensorial o algún cambio electroquímico) si entran iones cargados positivamente, ese potencial de equilibrio, que es negativo, de golpe salta y produce un potencial positivo. Eso dispara un spike. Ese spike se transporta hasta las dendritas y se transmite a una célula vecina. Ese es el principio básico de transmisión de la información: el potencial de acción. Cada potencial de acción está introducido por una neurona y existen billones de ellas. Todos esos potenciales, además, están correlacionados entre sí. Entonces por eso es un problema extremadamente complejo, delicado e interesante. Porque como esos potenciales son los que transmiten la información, tenemos que tener en cuenta un sistema muy desincronizado.

–¿Cuál es la unidad de información que se transmite?

–Bit. El problema de los ingenieros es el problema de los ceros y unos. Se podría pensar que el código neuronal, si uno toma ventanas temporales muy muy pequeñas (de diez milisegundos, por ejemplo), es una suma de muchos ceros y unos en la cual cada neurona aporta ceros y unos. Pensándolo como una computadora, el código neuronal es justamente eso: muchos ceros y unos, en los que si uno encuentra un patrón estaría decodificando la información. En ese sentido es un problema muy matemático e ingenieril. Esa idea de código binario es muy de ingenieros, de hecho. Pero bueno: hay hipótesis fuertes de que la información se transmite a través de estos spikes.

–¿Usted hace trabajo teórico?

–Sí. Me gustaría empezar a hacer cosas experimentales: si pudiera sumar a un biólogo sería brillante. Mientras tanto, estoy tratando de explicar ciertos comportamientos con modelos matemáticos y físicos.

–¿Algo más que quiera contar?

–El código neuronal es como la Piedra de Rosetta, que tenía tres lenguajes. Nosotros en ese momento no conocíamos el idioma de los egipcios antiguos: a través de la comparación de esa piedra con los jeroglíficos que ya se conocían se logró comprender el egipcio antiguo. Esto es un poco lo mismo: uno no conoce cómo el cerebro transmite la información, pero sí sabemos que los spikes juegan un rol fundamental.

–¿Spike es “chispa”?

–Chispazo, digamos. Se produce en una célula: está cargada negativamente y de golpe dispara, pasa de tener un potencial negativo a tener uno positivo. Cuando está negativo tiene unos 70 minivolts y salta a unos 20 o 25 minivolts positivos. Cuando se produce ese disparo se dice que se produce el spike. Eso juega un rol muy fuerte en el código neuronal. Es como traducir una Piedra de Rosetta: vamos a tener muchos ceros y unos y tenemos que ver cómo se correlacionan. De ahí vienen todos los modelos matemáticos de sistemas dinámicos y de teoría de la información. Es un gran desafío.

-

DIáLOGO CON FERNANDO MONTANI, DOCTOR EN FíSICA E INVESTIGADOR DEL CONICET

Por los insondables caminos del cerebro

Por Leonardo Moledo

ESCRIBEN HOY

- Alejandro Aymú y Luciana Mignoli

- Andrés Valenzuela

- Beatriz Vignoli

- Cecilia Hopkins

- Claudio Scaletta

- Claudio Socolsky

- Cristian Carrillo

- Cristian Vitale

- Eduardo Videla

- Eduardo “Tato” Pavlovsky

- Eric Nepomuceno

- Facundo Martínez

- Felicitas Maini

- Gustavo Veiga

- Irina Hauser

- Javier Lewkowicz

- Juan Carlos Tizziani

- Juan G. Tokatlian, Agustín Colombo Sierra, Ernesto López, Luis Tibiletti y Pablo Martínez

- Juan José Panno

- Juan Sasturain

- Leonardo Moledo

- Luis Bastús

- Mariana Carbajal

- Matías Emiliano Casas

- Miguel Jorquera

- Patrick Cockburn

- Paula Sabatés

- Raúl Kollmann e Irina Hauser

- Sebastián Premici

- Sergio Sánchez

- Silvina Friera

- Tomás Lukin

© 2000-2022 www.pagina12.com.ar | República Argentina | Política de privacidad | Todos los Derechos Reservados

Sitio desarrollado con software libre GNU/Linux.